Qu’est-ce que la Dark IA ?

La Dark IA, également appelée IA malveillante ou IA sombre, désigne l’utilisation de l’intelligence artificielle à des fins malveillantes, telles que les cyberattaques, la fraude, les arnaques, les campagnes de désinformation et les atteintes à la protection des données. Dans certains cas, des programmes d’IA obscurs sont créés dans le but exprès de perpétuer ces actes malveillants, tandis que dans d’autres, des programmes d’IA neutres ou bénéfiques sont réaffectés pour causer des dommages.

L’IA sombre est généralement associée aux cybercriminels, comme les pirates, les arnaqueurs et autres fraudeurs, qui se servent de l’intelligence artificielle pour créer ou déployer leurs stratagèmes. Elle peut leur permettre de lancer des attaques ou des arnaques plus élaborées, plus rapidement et plus facilement qu’auparavant.

Toutefois, certaines définitions désignent également l’IA utilisée dans la guerre comme de la Dark IA. Israël a par exemple utilisé des programmes d’IA pour l’aider à sélectionner des cibles à Gaza. Dans la guerre entre la Russie et l’Ukraine, les deux parties ont employé l’IA à des fins telles que l’analyse des données du champ de bataille.

Les inquiétudes concernant le rôle de l’IA dans la guerre ont été alimentées en février 2025, lorsque Google a levé une interdiction de longue date sur l’utilisation de l’IA pour le développement d’outils de surveillance et d’armes.

Exemples de Dark IA

Parmi les exemples d’IA sombre, on peut citer les deepfakes nuisibles utilisés pour la manipulation et l’atteinte à la réputation, les programmes d’IA générative conçus pour rédiger des messages frauduleux et les logiciels basés sur l’IA conçus pour faciliter les cyberattaques.

L’IA peut être utilisée pour de nombreux types d’activités malveillantes, de la création de deepfakes à la facilitation de la fraude.

L’IA peut être utilisée pour de nombreux types d’activités malveillantes, de la création de deepfakes à la facilitation de la fraude.

IA par deepfakes

IA par deepfakes

Les deepfakes sont des médias créés par l’intelligence artificielle et conçus pour imiter au plus près la ressemblance d’une personne, que ce soit son visage, ses manières ou sa voix. Les vidéos deepfakes sont souvent utilisées pour créer des clips humoristiques qui se moquent des politiciens, des athlètes et des célébrités, mais elles peuvent également servir à nuire à la réputation d’une personne ou diffuser des fake news.

La pornographie deepfake est un problème de plus en plus préoccupant, au premier plan de la discussion sur le potentiel de nuisance de cette technologie. Par exemple, des écoles en Corée du Sud et en Espagne ont connu des épidémies de deepfake, les enfants créant et partageant des vidéos explicites de deepfake de leurs camarades de classe.

De nombreuses personnalités publiques de premier plan, comme la chanteuse Taylor Swift, le streamer Twitch Pokimane et la représentante américaine Alexandria Ocasio-Cortez, ont également été victimes de deepfakes.

Désinformation par l’IA

Désinformation par l’IA

La désinformation par l’IA implique son utilisation pour créer et partager des informations fausses, trompeuses ou infondées et d’autres ressources. Ces informations erronées sont souvent diffusées par le biais de deepfakes. Pendant la guerre de la Russie contre l’Ukraine, par exemple, les acteurs étatiques et les partisans ont utilisé à plusieurs reprises des deepfakes pour diffuser des informations erronées et de la propagande.

Bien que ces vidéos puissent être manifestement perçues comme des faux par certains, à mesure que la technologie s’améliore, les deepfakes vont gagner en réalisme. Les campagnes de désinformation menées par les États et les particuliers risquent donc d’être plus fructueuses à l’avenir.

Des sites de fausses nouvelles générées par l’IA apparaissent également en ligne, souvent avec des URL similaires à celles d’organismes d’information légitimes et bien connus, tels que CBS, la BBC, ESPN et NBC. Dans certains cas, ces sites utilisent l’intelligence artificielle pour résumer et reproduire les articles des sites qu’ils imitent. Cela peut se traduire par des formulations et des structures d’articles bizarres, introduisant des inexactitudes factuelles et des preuves trompeuses.

D’autres sites d’IA sombre sont spécifiquement conçus pour diffuser des fausses nouvelles. Par exemple, USNewsper.com se présente comme une source d’information nationale américaine légitime, mais il a été accusé d’être un site généré par l’IA enregistré en Lituanie. Ce site s’est fait connaître en diffusant de fausses affirmations selon lesquelles le retrait de Joe Biden de l’élection présidentielle américaine de 2024 était en fait un canular.

IA par phishing

IA par phishing

Les arnaqueurs peuvent utiliser l’IA sombre pour affiner et rationaliser les campagnes de phishing, qui consistent à envoyer des messages provenant de sources apparemment légitimes pour diffuser des malwares ou inciter les victimes à divulguer des informations sensibles ou à envoyer de l’argent.

Les cybercriminels peuvent tirer parti de modèles de langage étendus (LLM) légitimes pour donner une apparence plus réaliste aux e-mails d’arnaque. Bien que ChatGPT et d’autres LLM populaires comportent des restrictions — telles que des filtres de modération de contenu, des restrictions de données en temps réel, des détails techniques limités et des politiques d’exploitation éthiques et légales — elles peuvent être contournées par une formulation prudente. Cependant, les arnaqueurs peuvent également utiliser des Dark GPT, des programmes qui fonctionnent comme ChatGPT, mais sans les garde-fous.

Les arnaqueurs utilisent également la Dark IA pour rechercher et cibler des victimes en capitalisant sur la capacité de cette intelligence à traiter rapidement de grandes quantités d’informations accessibles au public. Ils peuvent rapidement extraire ces données de sources telles que les réseaux sociaux et les sites de recherche de personnes dans le but de déterminer qui pourrait être une cible vulnérable et la meilleure approche pour l’arnaquer.

Après avoir choisi une cible, ils peuvent également télécharger une biographie de la personne dans un Dark GPT et utiliser l’IA pour générer des messages de phishing convaincants et personnalisés. Cela permet potentiellement aux arnaqueurs de produire des attaques par SMS ou par e-mail à un rythme beaucoup plus rapide.

Fraude par l’IA

Fraude par l’IA

La fraude par l’IA désigne l’utilisation de l’IA sombre pour manipuler des individus, des systèmes ou des entreprises en vue d’obtenir des récompenses financières ou d’autres avantages injustes. Par exemple, des arnaqueurs se sont servis de fausses images de l’acteur Brad Pitt pour faire croire à une femme en France qu’elle entretenait une relation amoureuse avec lui, lui soutirant ainsi plus de 800 000 dollars.

Ce n’est pas la seule fois où la fraude par l’IA utilise des deepfakes de célébrités à des fins de tromperie. De nombreuses sociétés d’arnaque ont utilisé des imitations de célébrités générées par l’IA pour faire la publicité de leurs produits, comme un faux Tom Hanks faisant la promotion d’une assurance dentaire, une fausse Jennifer Aniston faisant la publicité d’un complément de santé, et une fausse Taylor Swift faisant la promotion d’un faux cadeau d’ustensiles de cuisine de marque Le Creuset.

L’IA a également été utilisée pour des fraudes à l’investissement, ce qui a contraint la FINRA (Financial Industry Regulatory Authority) à adresser des avertissements aux investisseurs. Par exemple, les fausses signatures de célébrités et les faux sites web d’entreprises ont permis de mettre en place des systèmes de « pump-and-dump », où les fraudeurs gonflent le prix des actifs, pour les revendre ensuite au plus haut et laisser les investisseurs avec des pertes.

Les fraudeurs à l’IA sont également connus pour utiliser la Dark IA pour manipuler sur les réseaux sociaux. En utilisant l’IA pour créer et gérer des centaines de faux comptes sur des plateformes comme X, ils peuvent rendre les arnaques plus crédibles.

Piratage par l’IA

Piratage par l’IA

Le piratage informatique est l’une des utilisations les plus importantes de l’IA sombre. Les pirates peuvent utiliser des programmes basés sur cette intelligence pour accélérer le craquage de mots de passe, contourner des systèmes de sécurité, automatiser les piratages et exploiter des données. Il est important de se rappeler que l’IA n’est pas infaillible et qu’il existe des moyens de se défendre contre les piratages qui reposent sur elle. Disposer de mots de passe robustes et uniques, par exemple, peut contribuer à atténuer le risque d’exposition à des techniques de craquage de ces mêmes mots de passe.

Exemples de Dark GPT

Les Dark GPT sont de grands modèles de langage (LLM) utilisés à des fins malveillantes. Ils utilisent un type d’IA appelé ANI (intelligence artificielle étroite) pour créer des chatbots. Ces GPT sont souvent des versions piratées ou jailbreakées de LLM légitimes, tels que ChatGPT, mais dans certains cas, ils sont conçus avec des intentions malveillantes.

FraudGPT

FraudGPT, peut-être le plus connu des Dark GPT, est disponible sur le Dark Web. Il est présenté comme une solution tout-en-un pour les cybercriminels. Il peut servir à effectuer diverses tâches, comme rédiger des malwares, des messages frauduleux et de pages web d’arnaques. De plus, FraudGPT est capable de détecter les fuites et les vulnérabilités au sein des réseaux, des systèmes et des applications, ainsi que de surveiller des sites, des marchés et des groupes ciblés.

WormGPT

WormGPT est un Dark GPT qui se concentre sur la création de malwares et d’autres codes malveillants. Disponible uniquement sur le Dark Web, on l’a particulièrement retrouvé dans la conduite d’attaques de type « business email compromise » (BEC). WormGPT a été formé à l’aide de données conçues pour imiter les techniques de piratage du monde réel, ce qui en fait l’un des outils de création de malwares les plus dangereux qui soient.

PoisonGPT

PoisonGPT a été conçu pour être un exemple éducatif de Dark IA. Créé par une société française de cybersécurité, PoisonGPT a été conçu pour démontrer la rapidité avec laquelle les LLM à source ouverte peuvent se voir injecter de la désinformation par des acteurs malveillants.

Comment se protéger des menaces de l’IA

Vous pouvez vous protéger des menaces de la Dark IA en utilisant des mots de passe forts et une authentification multifactorielle, en limitant votre présence en ligne, en examinant les e-mails et les SMS, et en vous en tenant à des sources d’information vérifiables. Voici un aperçu plus détaillé des principales mesures que vous pouvez prendre pour vous défendre contre les attaques de l’IA :

-

La prudence est de mise en matière de communication : Prenez le temps d’examiner correctement les e-mails et les SMS avant d’y répondre, même s’ils semblent provenir d’un ami, d’un membre de votre famille, d’un collègue ou d’une entreprise.

-

Double vérification des sources : Veillez à confirmer la validité de ce que vous lisez en ligne afin d’éviter de tomber dans le piège de la désinformation générée par l’IA. Si vous lisez par exemple un article qui semble important, vérifiez si d’autres sources bien connues rapportent la même chose avant de le croire.

-

Vérifier les écarts : Si vous pensez regarder une vidéo deepfake, prêtez attention à des détails tels que le visage et le cou, ainsi qu’aux défauts audio pour vous aider à déterminer s’il s’agit d’une fausse vidéo. Si quelque chose semble clocher, il y a généralement une raison.

-

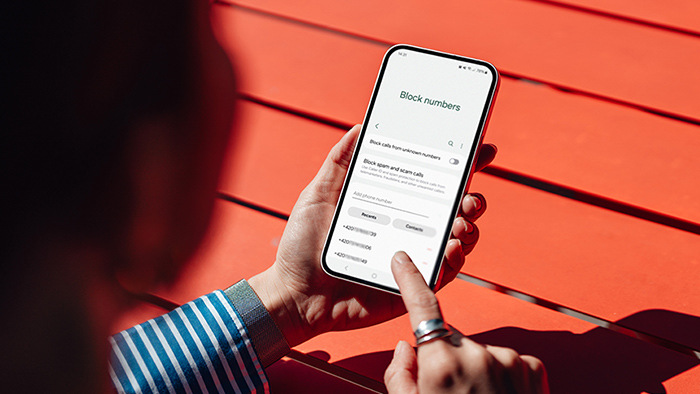

Utilisez des mots de passe forts : Utilisez toujours des mots de passe uniques et complexes pour vos comptes en ligne. Ainsi, même si l’un d’entre eux est compromis par une attaque de piratage de mot de passe par l’IA sombre, au moins vos autres comptes ne seront pas immédiatement menacés.

-

Activer l’authentification à deux facteurs : L’activation de l’authentification à deux facteurs (2FA) ajoute une couche de sécurité supplémentaire à vos comptes, empêchant les pirates d’y accéder même s’ils ont votre mot de passe.

-

Adopter une bonne sécurité Internet : Un programme antivirus robuste peut contribuer à protéger votre système et à supprimer les virus et autres malwares qui peuvent être installés si vous tombez dans le piège d’une attaque de phishing ou si vous cliquez sur un lien sur un faux site web.

-

Limitez votre présence en ligne : Les deepfakes ont besoin d’un matériel source à partir duquel une ressemblance peut être développée. Vous pouvez réduire le risque de vol de votre image en limitant la quantité de photos et de vidéos que vous partagez en ligne, ou au moins en appliquant des paramètres de confidentialité à votre profil Facebook et à d’autres comptes de réseaux sociaux.

-

Minimisez les données en ligne : Essayez de limiter les informations que vous partagez publiquement, comme votre anniversaire, votre lieu de travail, votre famille proche, etc. Cela limitera la quantité de détails que les arnaqueurs ou les pirates informatiques peuvent glaner pour créer des e-mails de phishing convaincants ou d’autres arnaques pour vous cibler.

Protégez-vous de l’IA sombre

La Dark IA évolue en permanence, rendant les cybermenaces plus trompeuses et plus dangereuses que jamais. Qu’il s’agisse de deepfakes, d’attaques de phishing pilotées par l’IA ou d’outils de piratage sophistiqués, les cybercriminels utilisent cette intelligence pour exploiter les vulnérabilités et manipuler les informations afin de servir leurs objectifs malveillants.

Protégez-vous en téléchargeant Avast Antivirus Gratuit : la solution de sécurité tout-en-un qui permet de détecter et de bloquer les arnaques, les malwares et les tentatives de phishing.